Découvrez pourquoi 87% des OKR échouent à cause de données dispersées et comment le data management transforme vos objectifs en résultats concrets. Guide complet + cas pratiques.

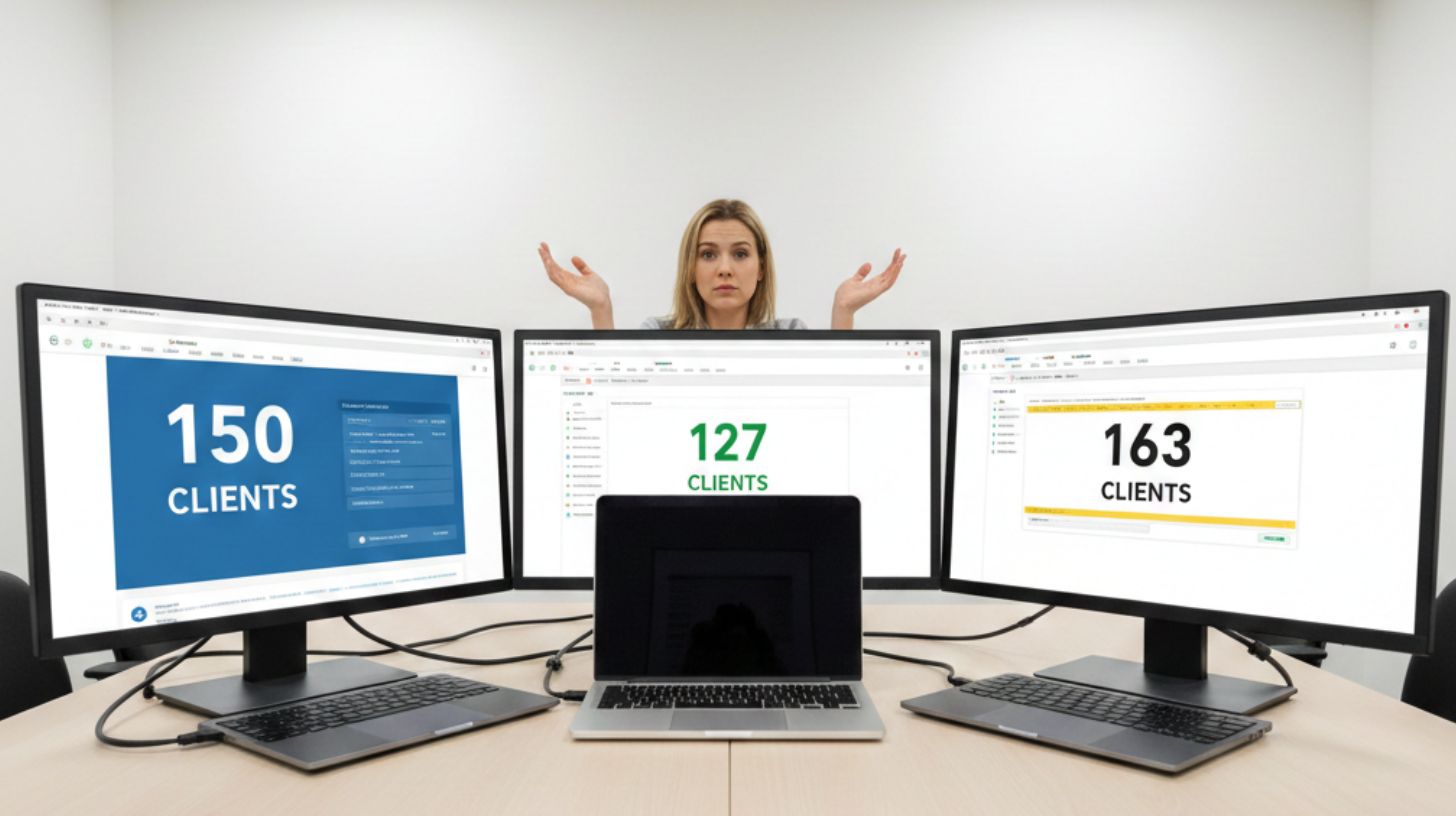

Aujourd’hui, toutes les entreprises parlent de données. On les collecte, on les stocke, on les transmet, on les analyse. Mais paradoxalement, plus la donnée est présente, moins elle est réellement comprise. Entre fichiers Excel disséminés, définitions différentes selon les équipes et traitements réalisés sans véritable méthode, la donnée devient vite source de confusion plutôt que de valeur.

Pourtant, avant de parler d’IA, de tableaux de bord ou de prédiction, il faut commencer par le début : qu’est‑ce qu’une donnée, au juste ? D’où vient‑elle ? Comment se construit‑elle ? Pourquoi une même information peut‑elle changer de sens d’un service à l’autre ? Et surtout, comment faire pour qu’elle soit fiable et réellement utile ?

Lorsqu’elle est bien comprise, bien structurée et bien gérée, la donnée devient un véritable atout stratégique accessible à toutes les équipes, sans jargon, sans usine à gaz, et sans dépendre de fichiers nommés “version finale 3”.

Cet article propose de revenir aux fondamentaux : comprendre ce qu’est une donnée, comment la catégoriser, comment la fiabiliser et pourquoi une bonne gouvernance change tout. Une mise au clair indispensable pour construire un système d’information solide… et préparer sereinement les usages avancés, jusqu’à l’IA.

Pour bien comprendre ce qu’est une data, il faut la découper en catégories :

Lorsqu’on parle de données, il est essentiel de distinguer leur nature et leur finalité. En pratique, on oppose généralement les donnéesopérationnelles aux données analytiques.

Les données opérationnelles décrivent ce qui se passe, les données analytiques expliquent pourquoi et comment cela évolue.

Cette distinction structure naturellement les flux de données :

Cette séparation permet de clarifier les usages, d’améliorer la qualité des analyses et de garantir un cycle de vie cohérent entre données « qui font fonctionner l’activité » et données « qui font comprendre l’activité».

Ils indiquent d’où viennent les données dans l’entreprise, de quel service ou de quel métier. On peut ainsi parler de données commerciales, marketing ou financières.

Cela peut paraître évident, mais dans les faits, un même terme n’a pas toujours la même définition selon le service.

Exemples :

Comprendre d'où vient la donnée, c'est comprendre comment elle a été construite.

Il s’agit des données qui concernent la donnée. Pour faire simple, ce sont toutes les informations, date d’enregistrement, sources des données, typologies, etc., qui permettent d’avoir des informations sur la donnée.

Elles indiquent par exemple :

Elles apportent du contexte et permettent de juger de la qualité et de la fiabilité de la donnée.

Cela permet de connaitre la véracité des données. Une température issue d’un capteur IoT est une donnée difficilement contestable. En revanche, une température saisie manuellement dans un tableur après lecture d’un thermomètre est beaucoup plus discutable. Surtout si la personne qui effectue le relevé visuel n’est pas la même qui complète le tableur.

La source conditionne donc le niveau de confiance.

On va rencontrer trois types de formats de données :

Les données structurées, celles que l’on retrouve dans les bases de données, organisées, prévisibles, presque faciles à interroger.

Les données semi-structurées : ce sont vos tableurs avec la case commentaire. Nous allons retrouver des données structurées, mais des informations complètement libres. Un document texte est un excellent exemple : vous aurez les données non structurées contenues dans le texte, mais les informations structurées comme la date d'enregistrement, la version, le nom du fichier, et son rédacteur.

Les données non structurées : Images, fichiers multimédia, ce sont les données que l’on retrouve le plus, mais qui sont les plus difficiles à exploiter.

Avant d’apparaître dans un graphique et d’aider à la décision, une donnée passe par plusieurs étapes. À chaque étape, son niveau de véracité et sa pertinence pour un cas d’usage peuvent varier.

La donnée brute, et la data prise à la source, les données de température issues de mon IOT.

Les données agrégées, le fichier ou la base de données qui va contenir les informations de température de plusieurs sondes IOT

Les données nettoyées, On retire les erreurs, les doublons, les anomalies.

Exemple : si une sonde a été débranchée pendant deux jours, on supprime les valeurs nulles de cette période.

Les données utilisées : Ce sont les données transformées ou enrichies pour répondre à un cas d’usage précis.

Comprendre les étapes permet d’éviter les mauvaises interprétations.

Par exemple : les données de température d’été enrichies avec la météo ne doivent pas être utilisées pour analyser la consommation énergétique en hiver.

C’est souvent ce qui mène aux fameux fichiers “VF1”, “VF2”… dont on ne sait plus à quoi ils correspondent.

Il peut s’agir :

Identifier correctement le type de donnée permet de l'uniformiser, de mieux la traiter et de mieux la construire.

Comprendre ce qu’est une donnée, d’où elle vient, comment elle est construite et à quelle étape de traitement elle se trouve, n’est plus une compétence réservée aux experts. C’est devenu un prérequis pour garantir des analyses fiables et des décisions éclairées. Une bonne donnée, ce n’est pas seulement un chiffre juste : c’est une information dont on connaît l’origine,le sens, le format et le niveau de transformation.

Dans beaucoup d’entreprises, cette compréhension se perd entre tableurs, fichiers nommés « VF3 », exports multiples et définitions variables selon les équipes. C’est précisément là que les problèmes de qualité apparaissent — et où la confiance s’effondre.

L’ambition de Kyklos Data System est simple : rendre cetterendrecette gestion de la donnée accessible à tous, sans jargon, sans complexité inutile, et sans dépendre d’outils illisibles. Centraliser les données, clarifier leur définition, sécuriser leurs transformations : tout devient aussi intuitif qu’un tableur, mais aussi robuste qu’un système industriel.

Parce qu’une donnée bien comprise est une donnée bien utilisée.

Et une donnée bien utilisée, c’est le premier pas vers une organisation capable d'exploiter pleinement son information et prête pour l’IA.

Découvrez pourquoi 87% des OKR échouent à cause de données dispersées et comment le data management transforme vos objectifs en résultats concrets. Guide complet + cas pratiques.

La sécurité des données est passée d'un sujet technique confiné à l'IT à un enjeu stratégique qui impacte directement le business. Trois facteurs expliquent cette transformation radicale.

Pourquoi 87% des Entreprises Échouent à Atteindre leurs OKR ? C'est ce que nous abordons dans cet article qui vous permettra de fixer et piloter vos OKR